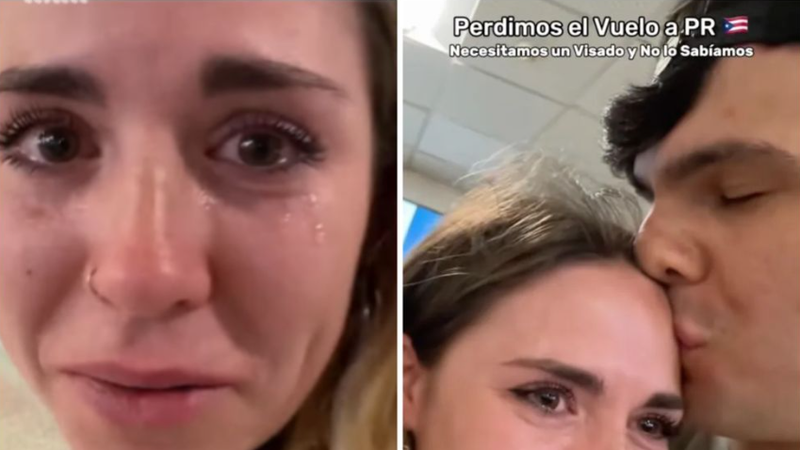

Doi influenceri spanioli, Mery Caldass și Alejandro Cid, s-au filmat în lacrimi după ce nu au fost lăsati să urce în avionul spre Puerto Rico. Motivul? Aveau documentele greșite, iar asta — susțin ei — e vina lui ChatGPT. „Întotdeauna fac mult research, dar am întrebat ChatGPT și mi-a zis că nu trebuie viză”, spune Mery, cu ochii roșii de plâns. Iar în mijlocul crizei de nervi, nu s-a putut abține să-l certe pe asistentul virtual: „Nu mai am încredere în nenorocitul ăla. Uneori îl insult, îi zic că e inutil, dar măcar să mă informeze corect… asta a fost răzbunarea lui.”

Clipul, postat pe TikTok, a strâns peste 6,1 milioane de vizualizări și mii de comentarii ironice. Un utilizator a scris: „Selecție naturală. Dacă pleci într-o călătorie transoceanică și îți iei toate informațiile de la ChatGPT, ți s-a întâmplat prea puțin.” Alții au întrebat retoric: „Dar cine se bazează pe ChatGPT pentru așa ceva?”

Cei care au luat apărarea AI-ului spun că, de fapt, ChatGPT nu a greșit complet: spaniolii nu au nevoie de viză pentru Puerto Rico, dar trebuie să obțină online o autorizație de călătorie ESTA — lucru pe care cei doi l-au omis.

Incidentul vine la o zi după ce un american de 60 de ani a ajuns trei săptămâni în spital, tot din cauza unui sfat „alimentar” dat de ChatGPT: în loc de sare de masă, acesta i-a recomandat… bromură de sodiu, o substanță toxică folosită la curățarea piscinelor. Omul a suferit halucinații, paranoia și o formă rară de intoxicație dispărută din spitale de peste un secol.

Se pare că, înainte să întrebi AI-ul orice, ar fi bine să-ți amintești: ChatGPT știe multe… dar nu e agent de turism, nici nutriționist și, mai ales, nu-ți poate plânge de milă când rămâi blocat în aeroport.

Potrivit legislației, suntem obligați să cenzurăm comentariile ce incită la ură, reprezintă atac la persoană sau conțin cuvinte necenzurate.

Vă îndemnăm la discuții decente!